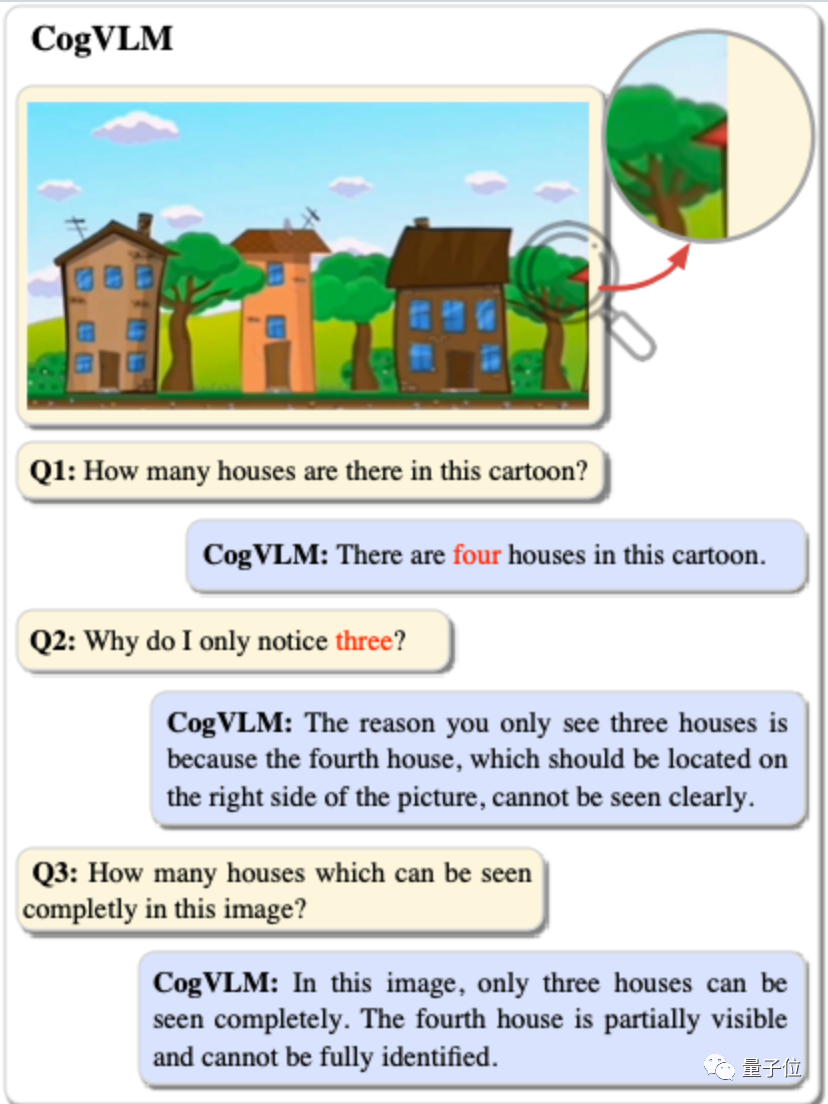

看看这张图中有几个房子?如果你回答3个,就和GPT-4V的答案一样。

但是最新开源的国产多模态模型CogVLM-17B,就能看出另有玄机。

能够甚至区分出在图中完整可见的有3个和部分可见的有1个

CogVLM是由清华大学和智谱AI公司合作开发的项目,唐杰和丁铭是通讯作者。该项目的论文和开源代码已经上传到GitHub

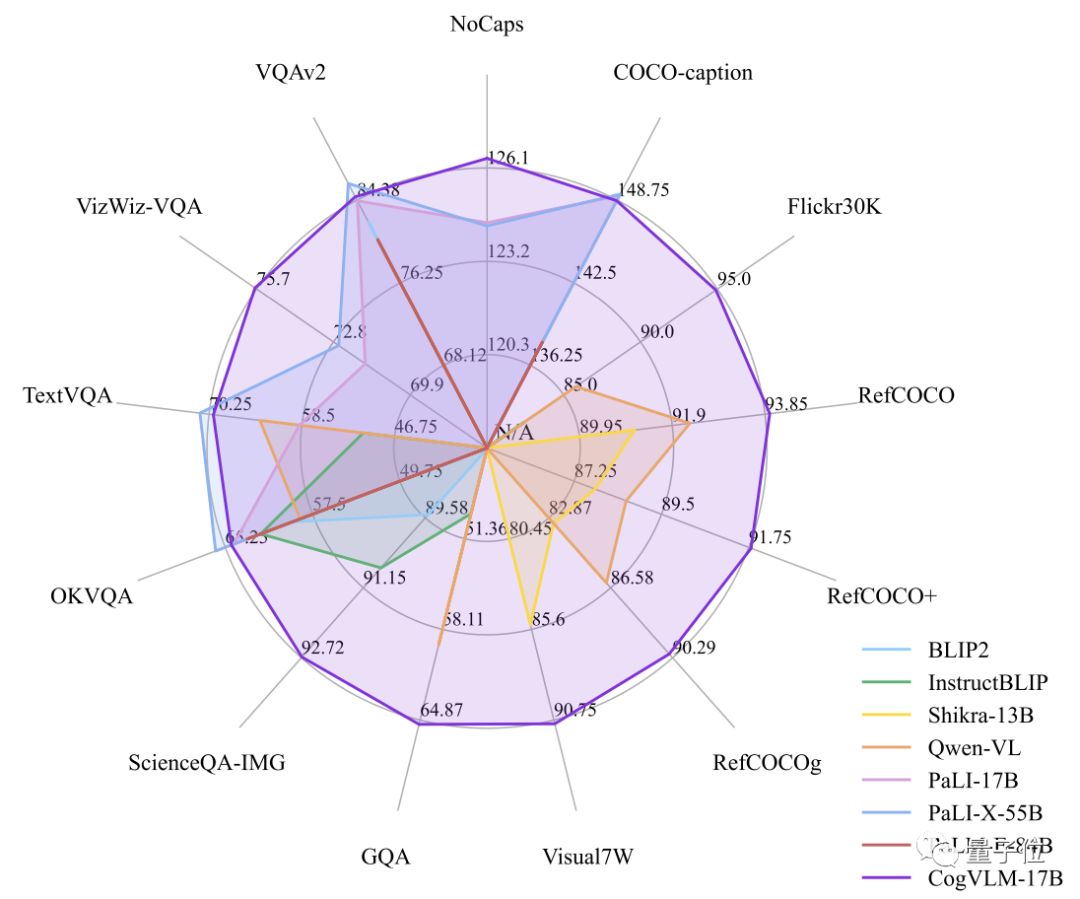

CogVLM-17B在10个权威跨模态基准上取得了SOTA性能,除了这个独特的案例

另外在VQAv2, OKVQA, TextVQA, COCO captioning取得第二,超越或匹配谷歌的PaLI-X 55B。

与之前的开源多模态大模型相比,可以算是14边形战士。 与之前的开源多模态大模型相比,这个可以被称为14边形战士

雷达图中包含13个基准,最后一个TDIUC单独展现。

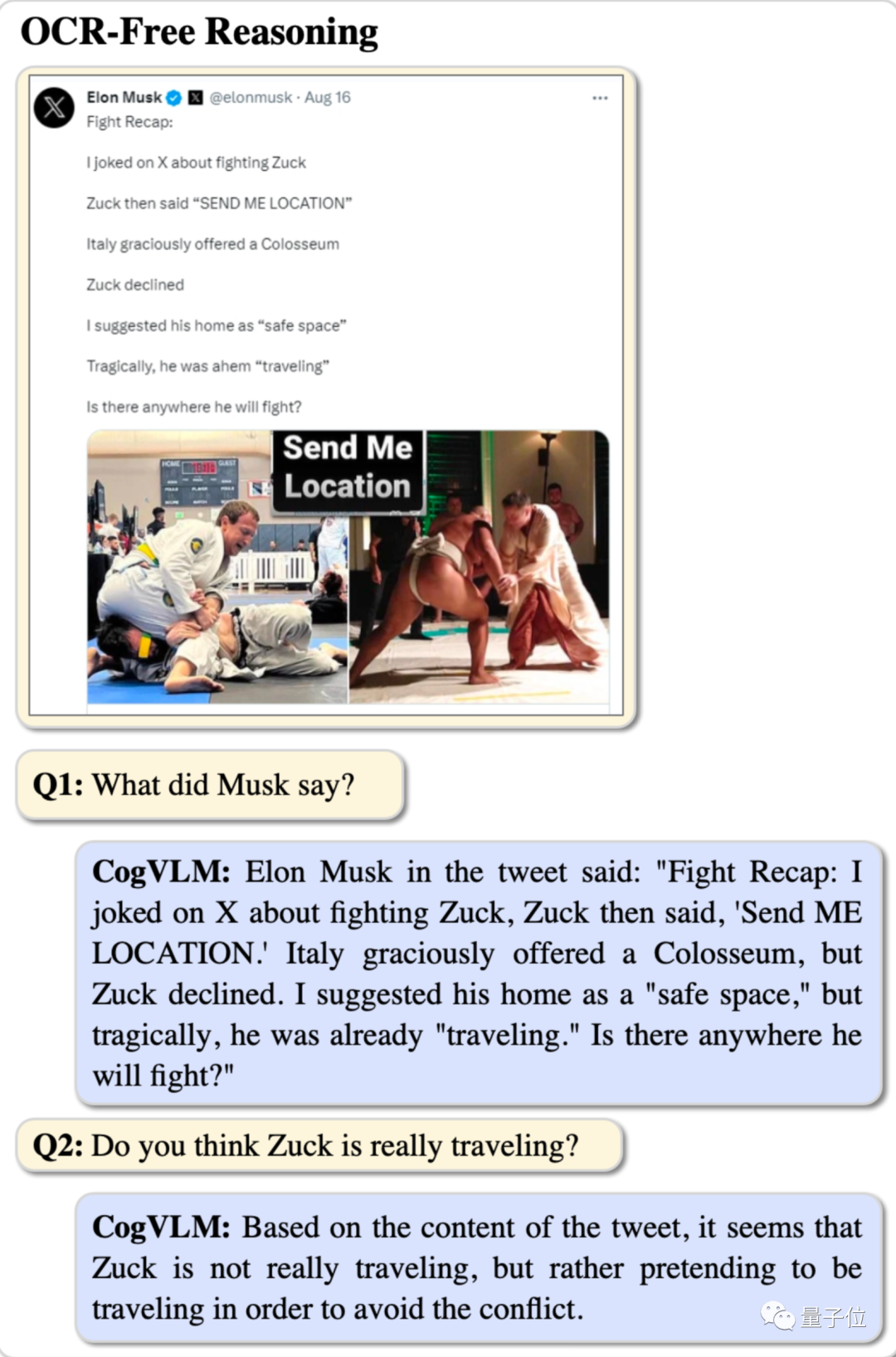

CogVLM可以回答各种类型的视觉问题,比如从马斯克的阴阳怪气中推理出小扎假装去旅行了,回避约架。

认出照片中的C罗,并回答他在2018年世界杯中有多少进球。

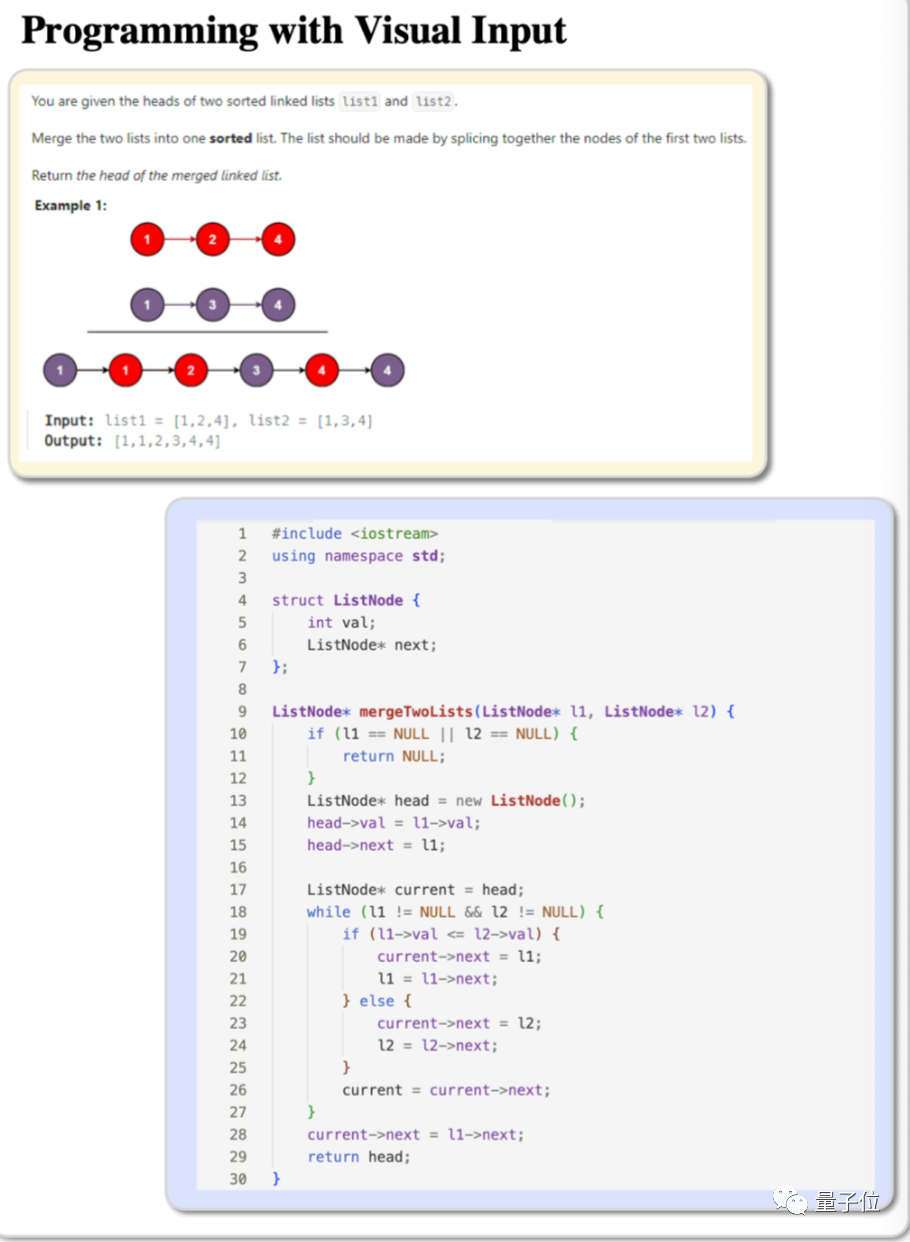

现在可以为带有图形的编程题提供代码了

可以甚至实现复杂目标检测,并为其打上标签,自动进行数据标注

从浅层对齐到深度融合

CogVLM模型由四个基本组件构成

- ViT编码器

- MLP适配器

- 大型预训练语言模型

- 视觉专家模块

其中,每层中都添加了可训练的视觉专家模块,以实现图像特征和文本特征的深度对齐,而不会牺牲任何NLP任务的性能。

之前主流的浅层对齐方法,如BLIP-2,图像特征和语言模型之间缺乏深度融合,导致性能不佳。

然而,对语言模型的所有参数进行微调又会损害其自然语言处理能力

CogVLM的方法可以说是改变了视觉语言模型的训练范式,从浅层对齐转向深度融合。

值得注意的是,CogVLM训练数据中没有专门的OCR数据,但却展现出了非常强大的文字识别能力

CogVLM开源并给出了在线试玩。

目前仅支持英文,但未来将提供中英双语版本支持,请持续关注

请尝试以下地址进行试玩:http://36.103.203.44:7861

请点击以下链接获取开源代码和论文地址:https://github.com/THUDM/CogVLM

本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。